Secciones

Servicios

Destacamos

Secciones

Servicios

Destacamos

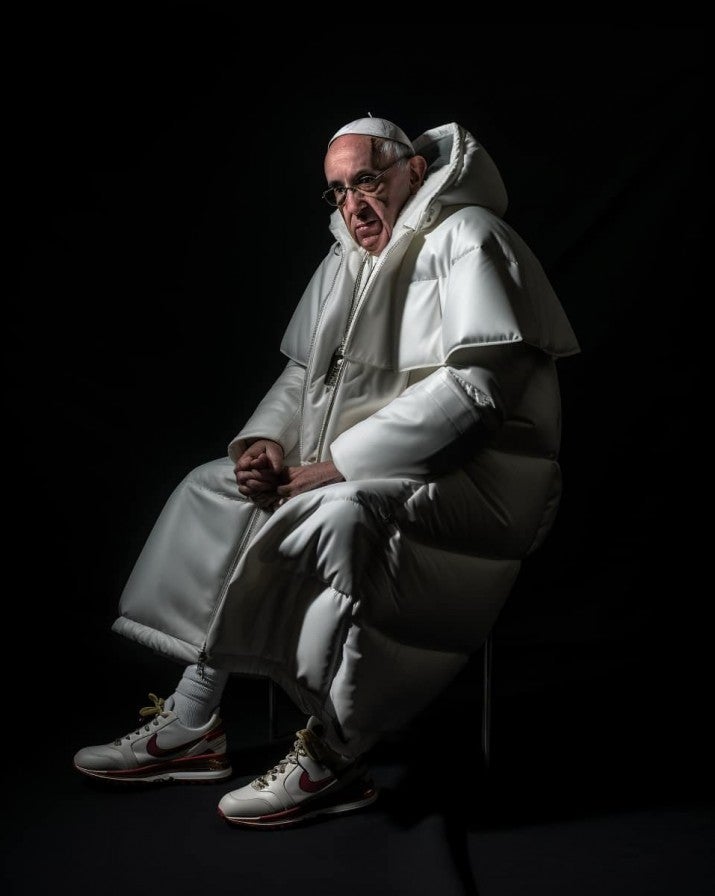

La Inteligencia Artificial que posibilita cribados más efectivos de cáncer de mama (un estudio sueco ha demostrado que gracias a esta tecnología se detectan un 20% más de tumores) y que ya es capaz de predecir el avance del fuego en los bosques de Las Hurdes (Cáceres) gracias a unos sensores en los árboles que detectan gases y miden la humedad y el viento es la misma que ha puesto al líder del PP, Alberto Núñez Feijoó, a hablar inglés, vistió al Papa con un plumífero blanco de Balenciaga, 'arrestó' a Donald Trump y también ha desnudado digitalmente a una treintena de chavalas de Almendralejo (Badajoz), cuyas fotos se han distribuido por las redes sociales. Es la cara y la cruz de esta prometedora tecnología que abre expectativas positivas y alienta miedos casi a partes iguales. Y que obliga a introducir la dimensión ética en el debate sobre a dónde nos lleva el acelerado desarrollo de una herramienta sobre la que sus propios artífices han expresado ya sus temores.

En marzo, los padres de la IA llamaban a parar un tiempo para frenar lo que ellos mismos calificaban de «carrera descontrolada». En mayo, el informático británico Geoffrey Hinton, padre de la IA y premio Princesa de Asturias de Investigación Científica, dejaba Google y alertaba sobre los peligros de esta nueva tecnología. En junio, el Parlamento Europeo acordaba regular el uso de la IA por amplia mayoría (499 votos a favor frente a 28 en contra y 93 abstenciones) y promovía un código de buenas prácticas voluntario para empresas tecnológicas. Pero, estos días, el grotesco caso de las falsas fotos desnudas de las niñas de Almendralejo ha puesto en evidencia que todas estas medidas y advertencias se han vuelto papel mojado, al menos en la práctica. «El discurso actual de la Inteligencia Artificial se ha quedado en la trampa. Es una verguenza que se puedan hacer 'deepfakes', vídeos, imágenes o audios que imitan la apariencia real. Pero no pongamos la mirada solo en la tecnología, como si eso se hiciera por sí solo. Antes de Internet, las chicas ya tenían que aguantar en el colegio comentarios sobre lo corta o lo larga que llevaban la falda. Internet y, muy especialmente la IA, lo que supone es un cambio de escala», reflexiona Amparo Lasen, socióloga y profesora de la Universidad Complutense de Madrid.

A finales del año pasado, cuando la aplicación de IA ChatGPT consiguió el hito de convertirse en semanas en palabra de uso cotidiano –la FundéuRAE eligió Inteligencia Artificial como 'palabra del año 2022'–, nos entreteníamos con las monerías que era capaz de hacer la máquina. Era la novedad, un juguete con el que a golpe de click podías convertir a Bilbao en un escenario de la película 'Star Wars' o colocar a Tom Cruise como un turista más fotografiándose en el Puente Colgante... No tardaron en asomar los pícaros: una imagen creada con IA burló a los jueces y ganó un concurso de arte, lo mismo sucedió en otro de fotografía y hasta en un concurso de relatos infantiles organizado en Bizkaia, en el que se descubrió que uno de cada cinco relatos presentados no lo había escrito el chaval que lo firmaba, sino un programa de Inteligencia Artificial.

La cosa pasó a mayores y elevó el tono del debate mediático cuando esos mismos estudiantes se pusieron a hacer trampas en los exámenes. Ya no tenían que rebuscar en 'El rincón del vago' para copiar un trabajo porque ChatGPT lo hacía más rápido. ¿Nuestro sistema educativo en crisis? «Yo no demonizaría estas herramientas porque si un chaval busca un resumen o un manual o un trabajo en ChatGPT y luego verifica esa información ya está haciendo investigación y aprendiendo. Lo que tenemos que hacer es repensar los sistemas de evaluación. No le evalues con un resumen de un libro que puede sacar, sin leerlo, de una app de IA. Mándale que haga una reflexión personal sobre el tema que aborda ese libro o que participe en un debate, trabajos que ChatGPT no sabe hacer», propone Amparo Lasen.

Pero esa 'vigilancia' que pueden extremar los profesores en el aula no puede luchar contra las noticias falsas que se camuflan entre las verdaderas en el gigantesco universo mediático digital. El actor Stephen Fry, narrador de los audiolibros de 'Harry Potter', denunciaba hace unos días que habían utilizado sin permiso su voz para un documental: «Podían haberme hecho leer cualquier cosa, desde una llamada para asaltar el Parlamento hasta porno duro». De hecho, a otra actriz de la misma saga, Emma Watson, una aplicación de clonación de voz le puso a leer en Twitter (ahora 'X') un fragmento del 'Mein Kampf' de Adolf Hitler. El también intérprete Bruce Willis aparece en anuncios que nunca ha rodado, al señor Cuesta de 'Aquí no hay quien viva' le vemos de protagonista de la serie pero en plan sitcom americana y no poca burla se ha hecho con las intervenciones falsas en inglés de Leo Messi (el vídeo es tal creíble que es lógico que se dé por bueno), Belén Esteban (este está menos logrado), Chelo García Cortés o el líder del PP, Núñez Feijoó, entre otros.

✨️La Ana Rosa del pasado te invita a ‘TardeAR’✨️

— Unicorn Content (@unicorntves) September 13, 2023

📺 Estreno el lunes a partir de las 17:00h en @telecincoes .#TardeAR pic.twitter.com/bjQVn5xm1S

Ana Rosa Quintana recurrió a la IA para publicitar su nuevo programa, 'TardeAR', presentándose con una imagen de hace 35 años. Eso fue a propósito. No así lo que sucedió con su antigua competidora de las mañanas televisivas, Susanna Griso, que contaba con fastidio y sorpresa que en una exposición de ARCO se encontró con una imagen suya y de otras presentadoras que se habían utilizado para simular felaciones en una obra de carácter sexual: «Pregunté si era denunciable y me dijeron que era arte», ha contado Griso. «En el caso de las personas famosas, el círculo de protección de su intimidad no es tan amplio como en el caso de un ciudadano anónimo. Por su condición pública están más expuestas y habría que valorar la gravedad de la burla en cada caso, si se ha podido cometer un delito de injurias o contra la integridad de esa persona», orienta Mónica Caellas, profesora de Derecho Penal Tecnológico en UIC Barcelona.

Más allá del perjuicio causado para el afectado, la posibilidad de equívoco para el internauta. ¿Cómo saber ya qué es real y qué no? Para evitar estos errores, el Parlamento Europeo quiere etiquetar los contenidos creados con Inteligencia Artificial (imágenes, vídeos, textos…) con una 'marca de agua' que permita a los usuarios reconocer de un primer vistazo que esa imagen ha sido manipulada mediante esta tecnología. «Cualquier ley en este sentido debe ser, como mínimo, europea. Y mejor mundial porque no estamos ante una cuestión local. No sirve de nada que España, por ejemplo, imponga unos límites al desarrollo de un software si Francia no lo hace», advierte Mónica Caellas.

Y añade un matiz que es más que eso: «Poner límites al desarrollo de la Inteligencia Artificial es complicado porque también es una tecnología positiva que traerá grandes avances en medicina y en otros campos». Aunque esto también tendrá su precio. La Organización para la Cooperación y el Desarrollo Económicos (OCDE) calcula que en España hay un 28% de empleos en riesgo de automatizarse en los próximos años por esta causa y algunos sectores lo están sufriendo ya. El mundo del cine por ejemplo. Una docena de empresas de comunicación estadounidenses, entre ellas Disney y la CNN, han bloqueado ChatGPT en sus webs para evitar que entre y recopile contenidos. Y los guionistas han levantado la voz porque si existe una herramienta capaz de generar un guión de película o de teatro a partir de una sola frase que explique el argumento, ¿qué pasará con ellos?, ¿qué pasará incluso con los propios actores si una máquina ya es capaz de replicar sus cuerpos y sus voces con fidelidad?

«La Inteligencia Artificial tiene esa doble cara», alerta Mónica Caellas. Y estamos viendo la más fea: «Algo está fallando. Estamos asistiendo a episodios de violencia». Se refiere a los desnudos falsificados con una herramienta de Inteligencia Artificial de una treintena de chavalas en Almendralejo (Badajoz). Caso al que siguió otro similar con una veintena de víctimas adolescentes en Ayamonte (Huelva), desnudadas no ya con IA, pero sí con Photoshop -estas imágenes se distribuyeron luego en diversos grupos de WhatsApp-. La Policía ya ha identificado a una decena de menores de entre 12 y 14 años en el caso extremeño y a un adolescente de 16 como presunto responsable del delito de Huelva.

– ¿Estamos protegidos por la ley ante estos casos o hace falta tipificar nuevos delitos?

Caellas: El Derecho va a la velocidad que va, mientras que la tecnología avanza tremendamente deprisa. Ese desfase, que ya existía, es exagerado con la irrupción de la Inteligencia Artificial. Pero el Código Penal contempla ya los delitos en los que se encuadran estas actuaciones. En el caso de las menores de Almendralejo estamos ante un posible delito de pornografía infantil. Y podría haber otro delito vinculado, el ataque a la intimidad y a la integridad moral. Habría que valorar el daño causado a las víctimas a nivel reputacional, las lesiones psíquicas que pudieran presentar derivadas de la publicación de esas fotos falsas. El delito contra la integridad es un cajón de sastre porque se puede atentar contra él de muchas maneras y la legislación no define exactamente la conducta, como sí sucede con el delito de pornografía infantil. El margen a la interpretación del juez es mucho mayor.

Si el autor de esas fotos fuese un adulto, prosigue Caellas, «podrían caerle hasta 9 años de cárcel por el delito de pornografía y hasta 2 en el caso de vulnerar la integridad de las menores».

– Pero todos son menores.

Caellas: A los menores se les aplica la misma tipología de delito que a los adultos. Es decir, lo que es delito para un mayor lo es para un menor. La diferencia radica en las consecuencias.

Que también difieren si el menor tiene más o menos de 14 años. «Si tiene menos de 14 años es inimputable, no se puede hacer nada por la vía penal. Pero sí por la civil, reclamando una indemnización a la familia o tutores de ese chaval. En el caso de que se trate de mayores de 14, lo más grave es el internamiento por un periodo de dos años, camino legal compatible con la vía civil para exigir indemnizaciones económicas. De hecho, ambos procesos pueden ir por separado o integrarse en uno solo», explica la experta. Además, de manera paralela se puede solicitar la retirada de las imágenes de las páginas webs a través del 'Canal Prioritario' que hace cuatro años puso e marcha la Agencia Española de Protección de Datos (AEDP).

En cuanto a las consecuencias judiciales... ¿Van a internar a los mayores de 14 años que han creado o difundido las fotos falsas de sus compañeras desnudas? «Si las penas de los adultos ya están orientadas al principio de resinserción, en el caso de los menores, más. La máxima pena es el internamiento y lo siguiente en gravedad es el internamiento en régimen abierto (acuden al centro solo a dormir). Después, la libertad vigilada, con un tutor asignado que le hace un seguimiento para garantizar el cumplimiento de los objetivos que se hayan establecido que debe cumplir el menor: un curso de educación sexual si el delito fuera de ese tipo, acabar el curso escolar... Y, en un nivel más bajo, estaría el equivalente de los adultos de trabajos a la comunidad, que en el caso de los menores no tiene esa denominación pero sí son actividades que se les indica cumplir», explica Caellas.

En todo caso, queda aún para clarificar la pena. El protocolo es largo, pero bien definido. Cuestionados por el asunto de las menores de Almendralejo, desde el Tribunal Superior de Justicia de Extremadura explican a este periódico que «inicialmente la Policía tiene que hacer llegar el atestado al Juzgado de Instrucción. Cuando el delito lo ha cometido un menor se pasa a la Fiscalía de Menores. En este punto hay que diferenciar entre los acusados a los menores de 14 años y a los que ya habían cumplido esta edad en el momento de los hechos. En el primer caso, se archiva la causa; en el segundo, se instruye para definir qué delito se ha cometido e imponer la pena».

«Nunca habíamos llegado a estos extremos. Nos está sorprendiendo», reconoce María Bernal, secretaria general de la Asociación Española de Mujeres Juristas. Se refiere a los falsos desnudos de las adolescentes de Almendralejo y Ayamonte. «Se nos están presentando situaciones caóticas. Hay una libertad tremenda de acceso a herramientas informáticas, cualquier chaval tiene un móvil, sabe manejarlo y se están cometiendo delitos en el ámbito escolar, en grupos de amigos... Es un caos», advierte la letrada, que no ve un futuro mejor: «El problema de estas situaciones es que invitan a copiar. 'Si estos chavales lo han hecho, ¿por qué no nosotros?'». Comparte la preocupación la socióloga Amparo Lasen. Pero no tanto la sorpresa. «La conversación masculina sobre las mujeres siempre ha existido. La cosa es que ahora es pública, la dimensión ha cambiado. Los chavales, aunque no nazcan con el rol, lo aprenden. Y lo que interiorizan es que los chicos tienen el poder de controlar y humillar a las chicas y que la labor de ellas es intentar que no les pase». Las redes sociales posibilitaron la difusión masiva, pero la Inteligencia Artificial ha llegado para poner la puntilla. «Muchas chicas habían dejado de hacer topless en la playa por miedo a que les hicieran una foto, pero ahora ya no hace falta ni robarles la foto. ¿Para qué si te la puedes inventar usando una herramienta de IA?», invita a la reflexión Lasen.

Además de la vía judicial, las víctimas de los falsos desnudos y otros 'fakes' de la IA tienen un segundo camino para echar a andar: la Agencia Española de Protección de Datos (AEDP). Consultados por qué se puede hacer con este asunto, desde la AEDP explican el procedimiento. Y hacen una primera precisión: «La imagen de la cara de una persona es un dato personal». Y sujeto, por tanto, a protección. Para garantizarla, este organismo creó en 2019 el llamado 'Canal Prioritario': «Es una iniciativa pionera a nivel mundial que permite solicitar la retirada urgente de contenidos sexuales o violentos publicados en Internet sin el consentimiento de las personas que aparecen ellos. En el caso concreto de Almendralejo, la Agencia ha contactado con el Ayuntamiento para que difunda que se puede solicitar la retirada de las imágenes publicadas en Internet indicando las URLs desde las que se puede acceder a ellas». Sobre la efectividad del procedimiento, dan un dato: «En 2022 la Agencia realizó 51 intervenciones de urgencia para retirar información, imágenes, vídeos o audios que se habían publicado en Internet sin permiso y que mostraban contenido sensible ‒sexual o violento‒. En 46 de esos 51 casos se consiguió la retirada de los contenidos publicados con inmediatez, lo que supone más de un 90% de efectividad».

El asunto se complica, explica un portavoz de la AEPD, cuando la difusión es por WhatsApp o Telegram, por ejemplo. «La Agencia no puede solicitar la retirada de las imágenes en aquellos casos en los que la difusión se está produciendo mediante servicios de mensajería instantánea, ni por medio de correo electrónico. Pero sí tiene competencias para iniciar un procedimiento sancionador contra quien difunda o replique este contenido utilizando dichos medios tras identificar al infractor».

¿Ya eres suscriptor/a? Inicia sesión

Publicidad

Publicidad

Alfonso Torices (texto) | Madrid y Clara Privé (gráficos) | Santander

Sergio Martínez | Logroño

Sara I. Belled, Clara Privé y Lourdes Pérez

Esta funcionalidad es exclusiva para suscriptores.

Reporta un error en esta noticia

Comentar es una ventaja exclusiva para suscriptores

¿Ya eres suscriptor?

Inicia sesiónNecesitas ser suscriptor para poder votar.