Secciones

Servicios

Destacamos

Sábado, 1 de febrero 2025, 08:38

La Inteligencia Artificial (IA) ha iniciado una carrera tecnológica en campos como el de la ciberseguridad en el último año. De hecho, se espera que esta tecnología siga teniendo un importante impacto a lo largo de 2025, presentando tanto oportunidades como desafíos. En este sentido, ESET, compañía líder en ciberseguridad con sede en Europa, advierte sobre el impacto de esta tecnología en la evolución de las amenazas digitales y su repercusión en usuarios, empresas y gobiernos durante 2025.

En los últimos años, la IA ha sido una herramienta crucial para reforzar las defensas cibernéticas. Sin embargo, también está siendo utilizada por la ciberdelincuencia para amplificar ataques y mejorar técnicas de ingeniería social, fraudes relacionados con el robo de cuentas y la desinformación.

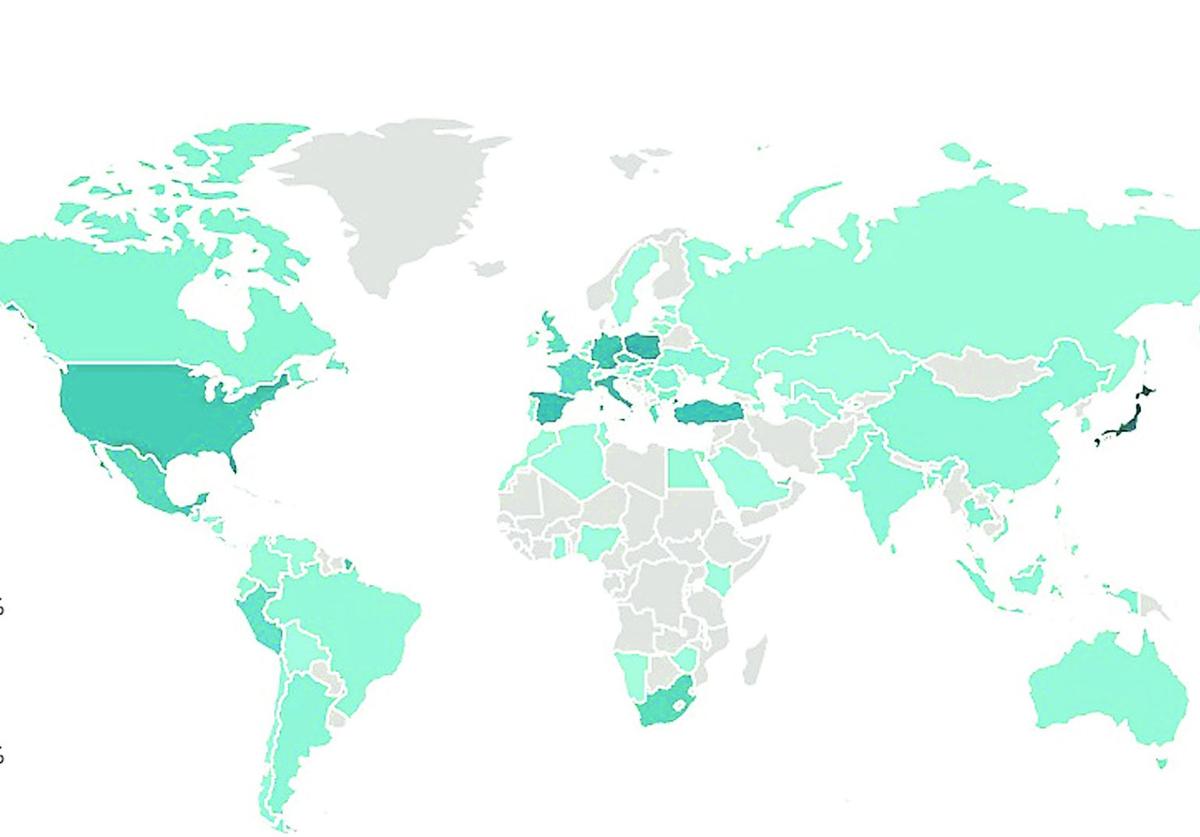

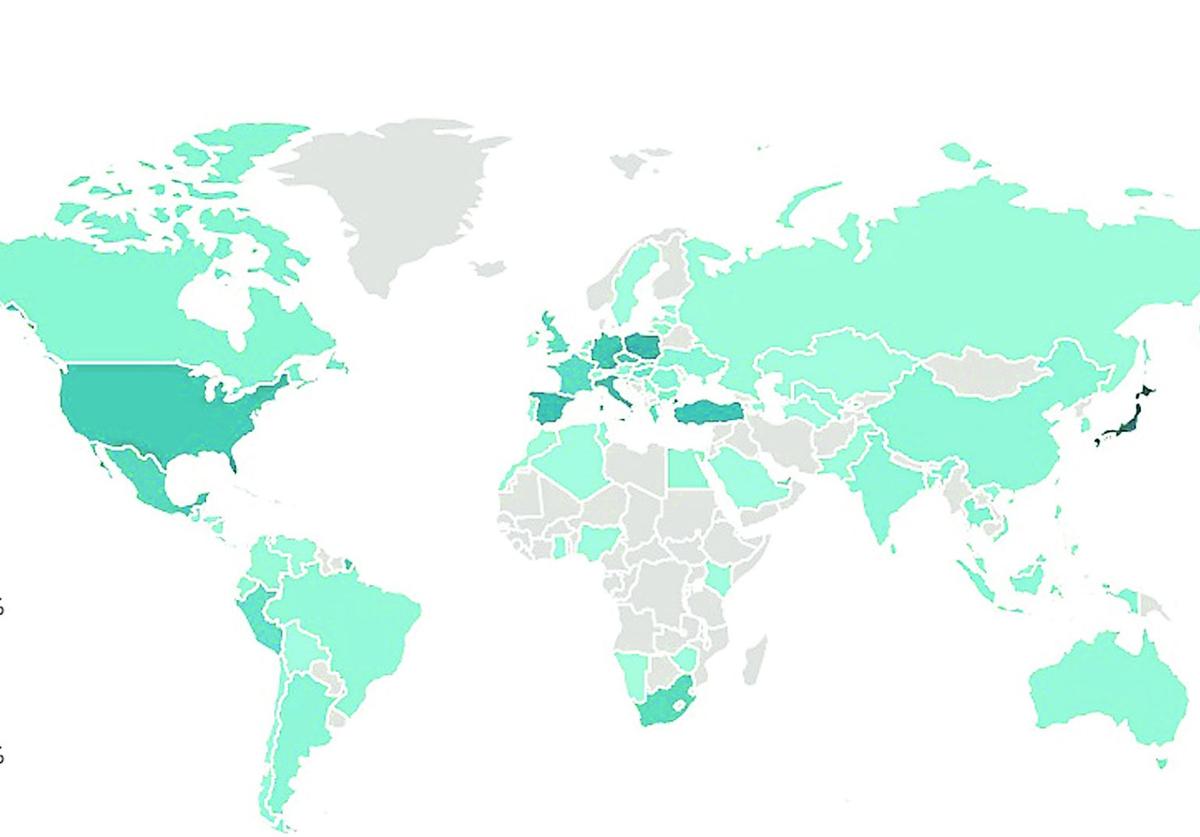

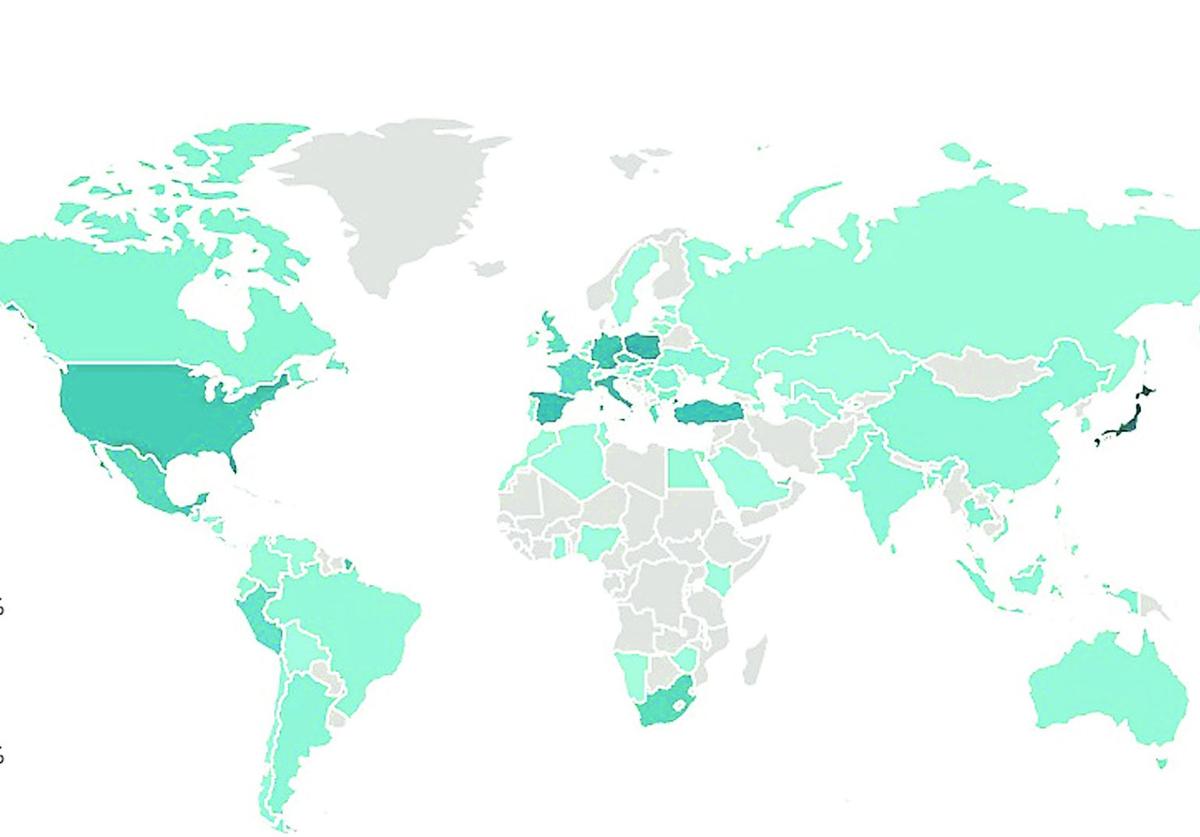

En el informe de ciberamenazas publicado por ESET a finales del pasado año, se destacaba que, durante el segundo semestre de 2024, se observó un incremento significativo en estafas que emplean videos deepfake y publicaciones fraudulentas en redes sociales para atraer a las víctimas hacia esquemas de inversión falsos. Estas estafas experimentaron un aumento del 335% en detecciones, siendo España uno de los países en los que más estafas de este tipo se detectaron junto a Japón, Eslovaquia, Canadá y República Checa.

La ciberdelincuencia utiliza la IA para sus campañas de fraude entre ellas:

· Elusión de autenticación: tecnología deepfake para superar verificaciones de identidad basadas en selfies o vídeos.

· Fraude corporativo: uso de IA para manipular a empleados y desviar fondos mediante correos electrónicos comprometidos (BEC) y vídeos falsos de altos directivos.

· Estafas de suplantación de identidad: los grandes modelos lingüísticos (LLM) de código abierto permiten a los atacantes imitar a sus víctimas potenciales en redes sociales, estafando a amigos y familiares.

· Estafas de influencers: los estafadores podrían usar GenAI para crear cuentas falsas y deepfakes.

· Desinformación ampliada: los ciberdelincuentes podrían emplear GenAI para generar contenidos falsos, aumentando su alcance y efectividad.

El uso masivo de datos para entrenar modelos de IA plantea serias preocupaciones. «Datos biométricos, información financiera y otra información sensible podrían estar en riesgo si los sistemas de IA son comprometidos»., alerta Josep Albors, director de investigación y concienciación de ESET España.

En paralelo, ESET recuerda que el marco regulador jugará un papel crucial en 2025. Mientras Estados Unidos podría desregular el sector tecnológico, en la Unión Europea persisten incertidumbres sobre la aplicación práctica de la Ley de Inteligencia Artificial. Estos factores podrían facilitar la proliferación de numerosas amenazas generadas por IA si no se abordan bien, por lo que, un enfoque colaborativo para minimizar riesgos y garantizar una experiencia más segura es esencial, según la compañía.

A pesar de estos riesgos, la Inteligencia Artificial desempeñará un papel cada vez más importante en el trabajo de los equipos de ciberseguridad en este año 2025, a medida que se incorpore a nuevos productos y servicios. Algo que desde hace años ESET aplica a sus soluciones de ciberseguridad, las cuales son el resultado de una constante investigación, experiencia humana y aplicación de innovadora tecnología. En este contexto, soluciones como ESET Endpoint Security es ejemplo de ello, ya que es una solución de seguridad integral que nació tras un gran esfuerzo por combinar el nivel máximo de protección con un impacto mínimo en el sistema. Las tecnologías avanzadas aplicadas a esta solución están basadas en la inteligencia artificial y son capaces de eliminar de forma proactiva la infiltración de todo tipo de malware, incluido el más avanzado, y otros ataques presentes en Internet sin dificultar el rendimiento del sistema ni interrumpir la actividad del ordenador.

Publicidad

Publicidad

Te puede interesar

Publicidad

Publicidad

Destacados

Esta funcionalidad es exclusiva para suscriptores.

Reporta un error en esta noticia

Comentar es una ventaja exclusiva para suscriptores

¿Ya eres suscriptor?

Inicia sesiónNecesitas ser suscriptor para poder votar.