Secciones

Servicios

Destacamos

Vivimos en un momento de conflictos bélicos internacionales preocupante y la violencia es una tendencia al alza tras décadas de esfuerzos por promover el diálogo y la paz. Ocurre en un momento en el que el desarrollo tecnológico atraviesa una época dorada, liderada por la aplicación de la inteligencia artificial a todo tipo de aparatos. El reconocimiento facial, por ejemplo, lleva unos años permitiéndonos desbloquear el teléfono, pero lo próximo parece ser aplicarlo a las armas.

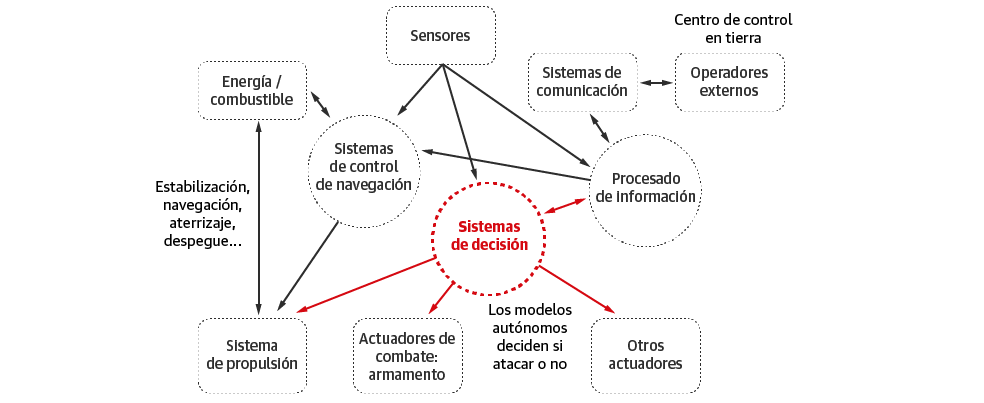

Hablamos de los LAWS, o sistemas letales autónomos, por su sigla en inglés, un tipo de armamento diseñado para tomar decisiones a partir del análisis, en tiempo real, de los datos que recopilan sus sensores y los que obtienen de la 'nube'. Es una tecnología que imita el funcionamiento del cerebro humano, basada en el aprendizaje automático (ML) ylas redes neuronales de aprendizaje profundo (DL), dos técnicas que permiten a los robots aprender y mejorar permanentemente sin necesidad de supervisión humana. Traducido al marco de la guerra, son sistemas que pueden determinar a quién matar y quién no, sin que un soldado que los controle, simplemente cruzando información.

Suman así una nueva categoría a la clasificación de los sistemas militares, divididos por Peter Burt, investigador especializado en inteligencia artificial y ex Director del Servicio de Información Nuclear de Reino Unido, en cuatro tipos: los sistemas inertes, como las municiones clásicas; los sistemas que funcionan por control remoto, como las bombas guiadas por láser; los sistemas automatizados, como los sistemas armados centinela; y los LAWS.

CLASIFICACIÓN DE LOS TIPOS DE TECNOLOGÍA SEGÚN EL GRADO DE AUTONOMÍA

1) Sistemas inertes

Proyectiles que no modifican su trayectoria. Una vez lanzados, no se puede actuar sobre ellos.

2) Controlados remotamente

Actúan según las órdenes que reciben a distancia. Son capaces, por ejemplo, de detonar o modificar su trayectoria, pero necesitan un operador externo (humano) que dé las instruccciones.

3) Sistemas automatizados

Siguen algoritmos o reglas preprogramadas. Son capaces de realizar seguimientos, por ejemplo, de objetos señalados o definidos previamente, pero es necesario indicarles previamente cómo comportarse en cada circunstancia.

4) Sistemas autónomos

Su toma de decisiones se basa en el análisis en tiempo real de los datos disponibles. Ya no es necesario indicarle cómo actuar en cada caso, porque la máquina es capaz de tomar decisiones y actuar según las circunstancias. Además, tiene capacidad para aprender.

La capacidad de tomar decisiones sobre quién vive y quién muere, al más puro estilo de 'Terminator', ha otorgado a los LAWS su apodo como 'killer robots' o 'robots asesinos', una tecnología que ya algunos autores han calificado como la 'tercera revolución de la guerra', tras la pólvora y el armamento nuclear.

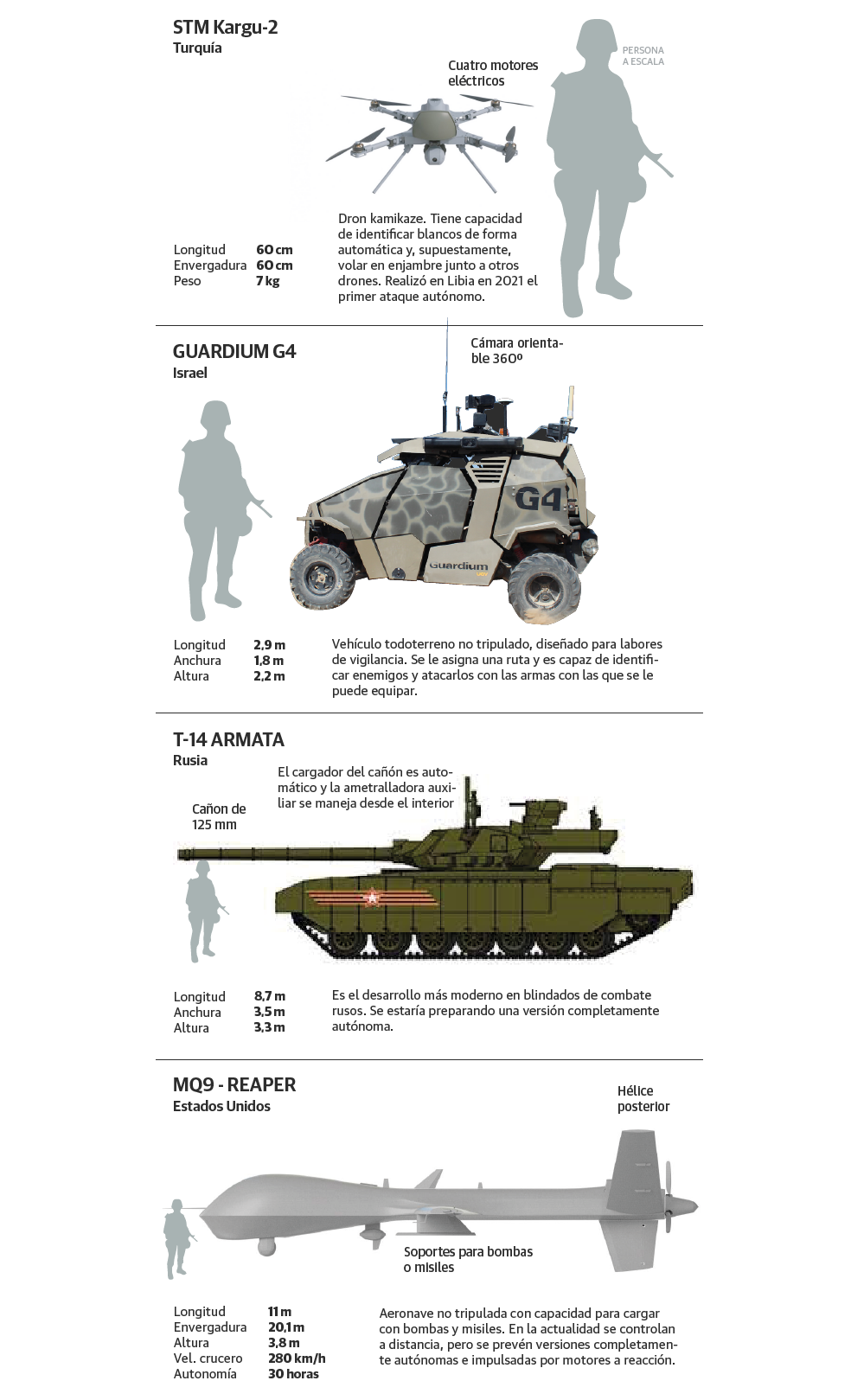

Un robot asesino puede adoptar muchas formas, incluso aspecto humanoide, pero lo más común es que sean drones. «Actualmente, Estados Unidos, Israel, Rusia y China son, junto con algunos países europeos, los grandes diseñadores y exportadores de drones militares a nivel mundial, pero se dispone de mucha menos información en el caso de los drones letales autónomos, al ser información clasificada por afectar a la seguridad nacional», explica Roser Martínez Quirante, profesora titular de la Universidad Autónoma de Barcelona, miembro del Comité Internacional por el Control de los Robots Armados (ICRAC) y coautora del libro 'Inteligencia artificial y armas letales autónomas' (Trea, 2018).

Preguntado por este periódico respecto a los esfuerzos que está invirtiendo nuestro país en el desarrollo de LAWS, desde el Ministerio de Defensa responden que: «pese a que el actual estado de la tecnología permitiría su desarrollo, en este Ministerio no se trabaja en ningún tipo de 'killer robots'». Sin embargo, España es uno de los países en contra de prohibir esta tecnología, junto a otros como Estados Unidos, Rusia, China, Australia, Turquía, Israel, Reino Unido, Italia, Francia o Alemania.

Martínez Quirante explica esta postura: «Es difícil lograr la connivencia de los estados para que quieran firmar el convenio de prohibir los sistemas letales autónomos, porque implica un coste económico y de posicionamiento geopolítico. Por un lado, dentro de una escalada armamentística global, el estado que permanezca al margen de la investigación, desarrollo e implementación de estos sistemas, se va a quedar indefenso ante la superioridad en inteligencia artificial que tengan otros. Por otra parte, implicaría una bajada del PIB (producto interior bruto), porque el sector de la informática y la inteligencia artificial es un mercado importante en algunos países, como España».

Los principales defensores de los LAWS argumentan que estas armas permitirán reducir el número de tropas combatientes desplegadas en el terreno, disminuyendo los costes de intervención y las bajas. Además, afirman que la inteligencia artificial es más fiable, eficaz y eficiente que la humana, al no tomar decisiones influidas por las emociones, lo que reducirá el margen de error, el número de víctimas y los crímenes de guerra.

«Si a una madre le dices que van a mandar un dron al campo de batalla en lugar de a su hijo soldado, ¿qué crees que preferirá? La población, antes de tener bajas humanas, se posiciona a favor de la inteligencia artificial, pero esa misma decisión supone que las guerras serán más fáciles de empezar y más difíciles de acabar, pues los políticos pueden oponer menor resistencia y reducir sus esfuerzos para comenzar y terminar los conflictos, al no estar tan presionados por el rechazo social a las pérdidas de vidas humanas, lo que supondrá una mayor escalada bélica y la deshumanización de la guerra», advierte Martínez Quirante.

Los detractores de esta tecnología alegan que a un dispositivo desprovisto de emociones le será más fácil matar. Plantean así preocupaciones éticas y legales: «Estos dispositivos son incapaces de reconocer el valor de la vida humana. Para ellos, una persona es un conjunto de bits de información. Si un dron mata a un civil por error, ¿a quién se le pedirán responsabilidades?», cuestiona la profesora.

Partes de un dron

Los críticos apelan, asimismo, a incógnitas operativas y tácticas, al existir serias dudas sobre la capacidad de desactivación de estos sistemas una vez situados en un contexto bélico; y problemas técnicos, pues la inteligencia artificial tiene un rango de error garantizado, al ser sensible al sesgo cultural de los datos. A modo de ejemplo, la Unión Estadounidense por las Libertades Civiles confirmó en una investigación que los sistemas de reconocimiento facial (como los que incorporan muchos drones) tienen una alta tendencia a identificar sujetos no caucásicos como criminales.

En cuanto a la comisión de crímenes de guerra, los opositores sostienen que este tipo de actos forman parte de la propia estrategia de los combatientes para desmoralizar al adversario, y que estas armas pueden propiciar otras violaciones del derecho humanitario internacional, como más ejecuciones extrajudiciales. Del mismo modo, afirman que la superioridad tecnológica de un bando que posee armas automáticas, frente a uno que no, hace que el conflicto sea desigual y asimétrico.

Cabe destacar también, en el trigésimo aniversario de la muerte de Isaac Asimov, autor de ciencia ficción y divulgación científica, celebrado el pasado 6 de abril, que los 'killer robots' violan las famosas Leyes de la Robótica que él describió en sus novelas y que han tenido una gran influencia en el desarrollo de la robótica real.

Un robot no hará daño a un ser humano o, por inacción, permitirá que un humano sufra daño.

Un robot debe obedecer las órdenes de un ser humano, excepto si estas órdenes entran en conflicto con la primera ley.

Un robot debe de proteger su propia existencia en la medida en que está protección no entre en conflicto con la primera o segunda ley.

Es difícil saber cuán cerca estamos de disponer de 'killer robots', lo que sí que se conocen son prototipos de armamento con algunas funciones autónomas, así como armas con potencial de ser modificadas para que adquieran autonomía. «Ya ha habido algunas evidencias de su uso. Naciones Unidas denunció en 2020 el empleo de robots asesinos en Libia, supuestamente de fabricación turca, con el dron STM Kargu-2. Es decir, no hablamos ya de un futurible, sino de un hecho presente y armas que están empezando a ser utilizadas en determinados escenarios bélicos», avisa Miguel Ángel Calderón, responsable de Comunicación en Amnistía Internacional España.

En cuanto al conflicto en Ucrania, «hemos visto que Rusia necesita sacar todo el armamento antiguo que tenía y que, paralelamente, está haciendo pruebas con algunos sistemas con inteligencia artificial, pero no tenemos ninguna certeza de que se hayan empleado de forma completamente autónoma. De todas formas, aunque se utilizasen, no se podría hacer nada al respecto, porque los 'killer robots' no están prohibidos», sentencia Martínez Quirante. «Lo que más preocupa, en general, son los enjambres de drones, es decir, mini drones que se comunican entre sí y actúan de forma coordinada, como si fuera un enjambre de abejas, pues es algo contra lo que es prácticamente imposible defenderse».

Por el momento, ningún país ha regulado sobre el diseño, la investigación, la producción o la tenencia de armas autónomas. Lo que sí se han alzado son muchas voces a favor de prohibirlas, dando lugar a la creación de una coalición internacional agrupada en la campaña 'Stop killer robots', que involucra entidades de la sociedad civil, del mundo del desarme, de los derechos humanos, empresas privadas y trabajadores de empresas del sector tecnológico y militar. Entre ellos se encuentran miles de científicos especializados en inteligencia artificial y personalidades tan reconocidas como el programador y cofundador de SpaceX, Elon Musk, o el cofundador de Google Deepmind, Demis Hassabis.

Sus protestas han impulsado las conversaciones en la Convención para Ciertas Armas Convencionales (CCW) de las Naciones Unidas, con el fin de prohibir los sistemas de armamento autónomo y pedir que haya un control humano significativo sobre el uso de fuerza letal. «La última convención tuvo lugar a finales de 2021 y fracasó, ante la oposición de algunas superpotencias militares, así que se decidió seguir estudiando la cuestión», lamenta Calderón.

Ambos especialistas aclaran que «no estamos en contra de la inteligencia artificial ni de los drones en remoto, porque en este caso la última decisión de si ese dron lanza un misil o no corresponde a una persona, que es la responsable de ese ataque si se produce algún error, pero que haya máquinas capaces de decidir de forma autónoma sobre la vida o muerte de las personas desafía los principios de los derechos humanos».

Un problema añadido de no regularizar los 'killer robots' bajo un marco legal es que pueden llegar a manos de cualquiera, de forma legal, incluidos los hackers. «Solo hay que recordar que, en Estados Unidos, la segunda enmienda de la constitución dice que cualquier persona americana tiene derecho a poseer y llevar armas, incluso de tipo militar», pone Martínez Quirante como ejemplo. «La esperanza es que aflore esta información en la población y que la gente entienda que la inteligencia artificial para fines benéficos es totalmente necesaria, pero que aplicada a fines bélicos puede llevar a consecuencias mucho peores que las que se quieren combatir. El control humano significativo de esta tecnología es lo único que nos va a salvar de un desastre».

¿Ya eres suscriptor/a? Inicia sesión

Publicidad

Publicidad

Alfonso Torices (texto) | Madrid y Clara Privé (gráficos) | Santander

Sergio Martínez | Logroño

Sara I. Belled, Clara Privé y Lourdes Pérez

Esta funcionalidad es exclusiva para suscriptores.

Reporta un error en esta noticia

Comentar es una ventaja exclusiva para suscriptores

¿Ya eres suscriptor?

Inicia sesiónNecesitas ser suscriptor para poder votar.