Secciones

Servicios

Destacamos

Jon Garay

Sábado, 6 de mayo 2023, 13:09

ChatGPT responde a la pregunta que todo el mundo se hace: ¿Es peligrosa la Inteligencia Artificial?. «La inteligencia artificial (IA) en sí misma no es peligrosa, ya que es solo una herramienta creada por seres humanos. Sin embargo, como cualquier otra tecnología, su uso indebido ... o malintencionado puede tener consecuencias negativas. Por ejemplo, si se utiliza para crear armamento autónomo, esto podría tener graves consecuencias para la seguridad mundial. También existe la preocupación de que pueda ser utilizada para automatizar trabajos que antes eran realizados por personas, lo que podría tener un impacto negativo en el empleo. Además, puede ser sesgada si los datos utilizados para entrenarla no son representativos de la población en general. Esto podría llevar a decisiones discriminatorias o injustas. Por lo tanto, es importante que se desarrollen y se implementen medidas de seguridad y ética». Así se ve a sí misma la Inteligencia Artificial (IA).

A estas alturas es difícil encontrar a alguien que no haya oído hablar de ChatGPT, Midjouney o Dall-E. El primero es el más conocido entre la última generación de herramientas de Inteligencia Artificial, que están causando una verdadera revolución. Valen para casi todo y prácticamente todo lo hacen bien. Elaboran textos, imágenes, vídeos, música, mejoran la productividad y hasta aprueban exámenes de Medicina.

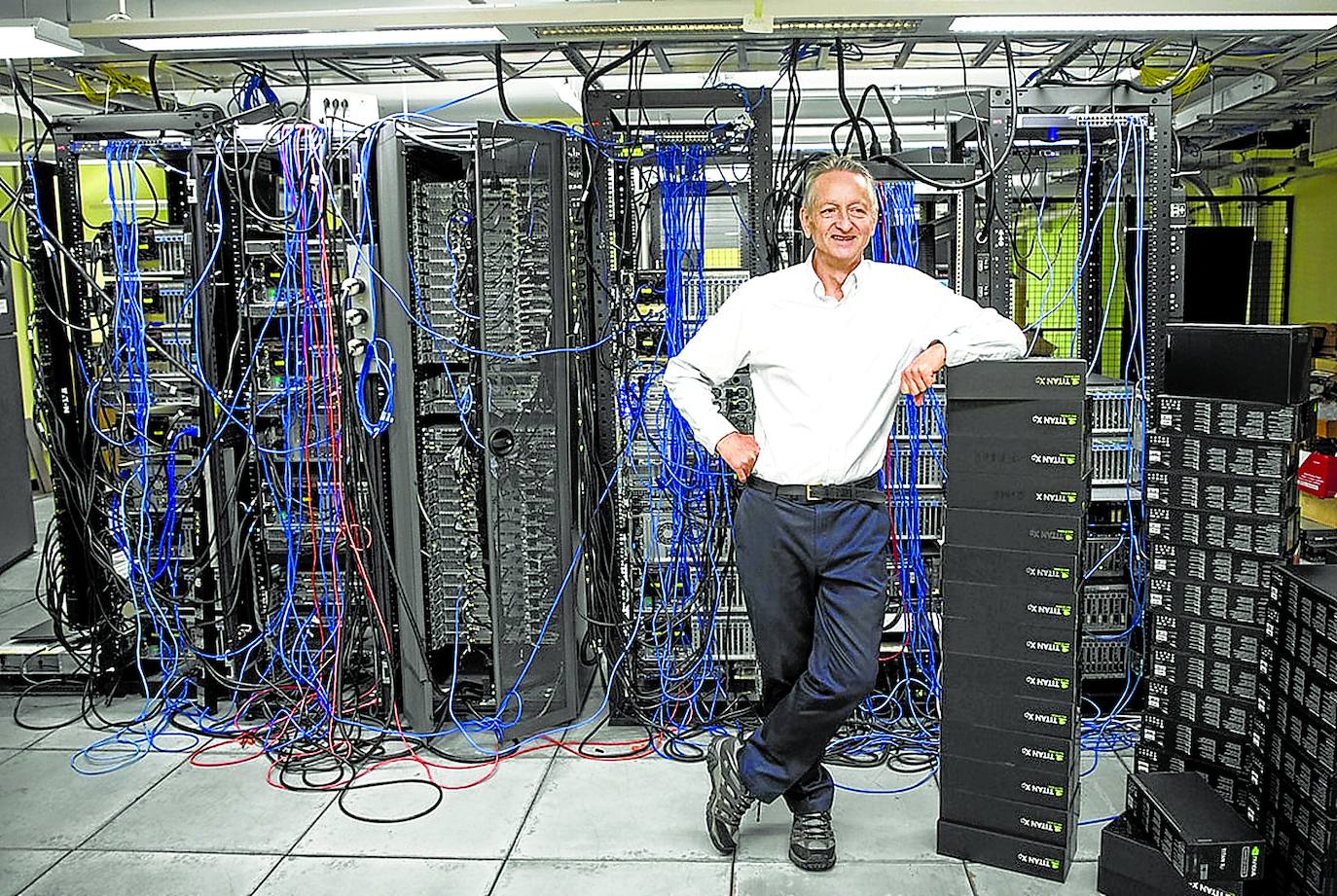

Pero es precisamente la velocidad a la que se están desarrollando estas herramientas la que ha generado alarma. Incluso entre algunos expertos. Hace apenas unos días Geoffrey Hinton, conocido como 'el padrino de la Inteligencia Artificial', dejó Google descontento con la dirección que está tomando la carrera por mejorar estos programas y advertía de sus peligros. Su salida de la compañía se sumaba a la carta remitida hace unas semanas por varios especialistas, entre ellos Elon Musk, propietario de Twitter y embarcado ahora en la carrera espacial con SpaceX, en la que reclamaban una pausa de seis meses en su evolución. «Los potentes sistemas de inteligencia artificial solo deberían desarrollarse cuando estemos seguros de que sus efectos serán positivos y sus riesgos controlables», decían.

¿Qué son exactamente estos programas? El aluvión de noticias en torno a la Inteligencia Artificial puede dar a entender que esta tecnología es algo nuevo, surgido hace unos años o incluso meses. Nada más lejos de la realidad, porque lleva entre nosotros siete décadas, desde que nacieron los primeros ordenadores. El matemático Alan Touring, el mismo que descifró el código enigma de los nazis, es considerado el fundador tanto de la informática como de la Inteligencia Artificial. El término fue acuñado en 1956 en referencia a una rama de la computación que trata de imitar las funciones cognitivas humanas. ¿Puede una máquina aprender, pensar, razonar o sentir como hacemos los humanos?

Los programas que se han hecho tan populares pertenecen a lo que se conoce como Inteligencia Artificial Generativa. ¿Cómo funcionan? Se introducen una enorme cantidad de datos y se les 'entrena' para combinarlos con una serie de técnicas conocidas como redes neuronales, que tratan de simular el funcionamiento de las neuronas y las sinapsis -las conexiones entre las neuronas- en el cerebro. No piensan, pero cuando se les pide algo generan un resultado después de 'cruzar' esa ingente cantidad de información que manejan. «No tienen conciencia, no hay un ser humano detrás. Dicen pero no saben lo que dicen. Es estadística avanzada», subraya Eneko Agirre, director de HiTZ, el Centro Vasco de Tecnología de la Lengua de la UPV/EHU y Premio Nacional de Informática SCIE-Fundación BBVA en 2021.

Volviendo a los riesgos de estas tecnologías, el doctor en Ciencias de la Computación y profesor de la Universidad de Málaga Juan Antonio Fernández-Madrigal es uno de los firmantes españoles de la carta que alerta de los peligros de la IA, que él centra en tres grandes áreas: el fraude, el ámbito laboral y el legal. El primero hace referencia a la práctica imposibilidad de distinguir lo que es verdadero de lo falso con los resultados de estos programas. «Textos, imágenes, audios… son casi indistinguibles de los que puede hacer un ser humano. Pensemos, por ejemplo, en un juicio. Estas inteligencias artificiales pueden elaborar pruebas legales, se pueden suplantar imágenes, audios… Yo las uso, pero no quiero cometer delitos. Otros, sí», explica.

Los más conocidos

ChatGPT: a más popular de estas herramientas. Lanzada en 2022 por Open IA, está diseñada para mantener conversaciones en el usuario. La última versión ha superado con éxito el examen para obtener la licencia médica en Estados Unidos. Tiene una versión gratuita y otra de pago.

Midjouney Con este programa de generación de imágenes se creó la imagen del falso arresto de Trump, la del papa Francisco con una parka muy similar a un modelo de Balenziaga o la de Putin arrodillado ante el presidente chino Xi Jinping.

Dall-E Otro programa de generación de imágenes. Pertenece a Open IA, la misma firma que está detrás de ChatGPT. Funciona con créditos. Ofrecen varios gratis con el registro y a partir de ahí se pueden comprar más.

Synthesia Permite crear crear vídeos a partir de texto. Pueden ser en hasta 120 idiomas diferentes.

Esta confusión lleva a otro problema más grave, porque «pone en peligro incluso la propia democracia por la facilidad para crear 'fake news'», añade el profesor. Una opinión que comparte otra de las firmantes de la misiva, Helena Matute, catedrática de Psicología de la Universidad de Deusto. «Asusta ver lo sencillo que es manipular a la opinión pública con estos sistemas. Es muy peligroso», subraya. Basta con pensar en la detención de Donald Trump días antes de su arresto real y recordar el asalto al Congreso estadounidense por parte de sus partidarios para comprender las consecuencias que pueden tener este tipo de montajes.

Según un informe de Goldman Sach, uno de cada cuatro empleos se destruirán en las próximas décadas y ahí está, precisamente, el segundo de los riesgos que entrañan estas tecnologías. «Las empresas buscan el máximo beneficio con el mínimo coste posible. Esto ha ocurrido siempre. Lo que pasa es que ahora el desarrollo de estos programas es tan rápido que los trabajadores no tienen tiempo para adaptarse. No hay sociedad democrática que pueda hacerlo», explica Fernández-Madrigal. «El verdadero reto social es cómo conseguir que las personas con menor formación puedan adaptarse a este nuevo mercado laboral», apunta, por su parte, el economista Javier García, que pone en contexto lo que está ocurriendo. «Cuando irrumpen este tipo de tecnologías se produce un efecto sustitución. Los trabajadores que no tienen estas habilidades pueden perder su empleo, pero se generan otros. En términos netos no está claro que se destruya empleo». «Quien te puede quitar el trabajo es quien sabe usar la inteligencia artificial, no la máquina», subraya Álex Rayón, vicerrector de Relaciones Internacionales y Transformación Digital de la Universidad de Deusto.

Noticia Relacionada

El tercero de los problemas que señala Fernández-Madrigal se refiere a la privacidad de los datos de los usuarios. Italia se ha convertido en el primer país en prohibir ChatGPT por no respetarla, y España ya lo está estudiando. La Agencia de Protección de Datos ha anunciado que investigará a Open AI en colaboración con otros países europeos, y Estados Unidos y China también han comenzado a dar pasos. «Damos nuestros datos alegremente. Nadie se lee las condiciones de uso. Y surgen los problemas de los derechos de autor. Si le pides a uno de estos 'bots' que elaboren una noticia, ¿de quién es el copyright? ¿De todos los autores de los que el programa ha obtenido datos?», se pregunta el experto.

Daniel Innerarity, catedrático de Filosofía Política y uno de los asesores de la Ley de Inteligencia Artificial en la que trabaja la Unión Europea, añade un cuarto campo de conflicto: el de la desigualdad. «Los datos con que se 'alimentan' estos programas pueden estar sesgados, de modo que pueden dar lugar a discriminación racial, por razón de género…», advierte.

Llegados a este punto, ¿es posible parar esta tecnología? ¿Habría que prohibirla? ¿Mejor regularla? Pese a firmar la carta, que ya suma más de 27.000 refrendos, el profesor Fernández-Madrigal es consciente de que detener su avance será «muy difícil. Hay muchas empresas que pueden obtener beneficios en estos momentos», reconoce. Como las del propio Elon Musk. El magnate participó en 2016 en la fundación de Open IA, la compañía que está detrás de Chat GPT, pero la abandonó dos años después. Ahora busca crear su propia firma de Inteligencia Artificial. Enrique Dans, profesor de Innovación y Tecnología en IE Business School, añade otra razón: la pérdida de competitividad. «Es una tecnología en marcha y no es posible detenerla porque ofrece una ventaja que es imparable. Si tú no la utilizas, lo hará otro país y dejarás de ser competitivo», razona.

Así las cosas, sólo queda la regulación. La Unión Europea trabaja en la llamada Ley de Inteligencia Artificial, una tarea para la que ha contado con el asesoramiento de un grupo de expertos, Daniel Innenarity, entre ellos. La aprobación de esta normativa está prevista para enero del próximo año, «aunque podría adelantarse. Después, cada país tendría dos años de plazo para aplicarla», explica. «Es una buena noticia», subraya la profesora Matute. Una pregunta queda en el aire: ¿cuánto habrán evolucionado estas herramientas para entonces?

¿Ya eres suscriptor/a? Inicia sesión

Publicidad

Publicidad

Te puede interesar

Publicidad

Publicidad

Esta funcionalidad es exclusiva para suscriptores.

Reporta un error en esta noticia

Comentar es una ventaja exclusiva para suscriptores

¿Ya eres suscriptor?

Inicia sesiónNecesitas ser suscriptor para poder votar.